- 文章标题:InstantID: Zero-shot identity-preserving generation in seconds

- 文章地址:https://arxiv.org/abs/2401.07519

- 技术报告

作者提出了InstantID,一种全新的ID一致的预训练文生图模型的调整方法。其在相同基础模型的模型下具有即插即用的特性。

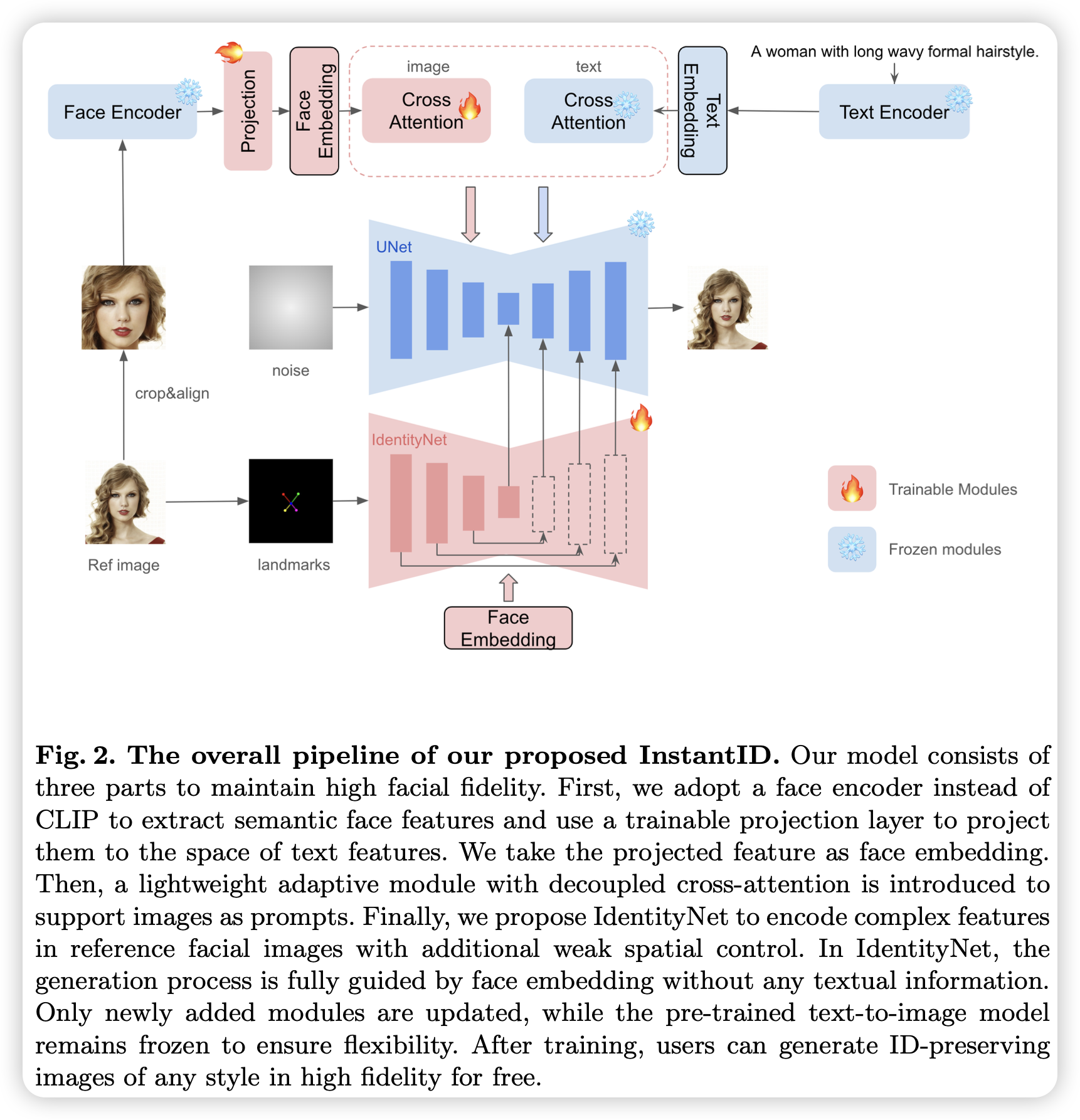

模型首先提取人脸的特征(使用专门针对人脸的模型而非CLIP,因为作者认为CLIP提取的特征具有很多人脸无关的信息,无法关注到人脸的细节特征),之后映射到文本特征空间,之后像IP-Adapter一样使用额外的交叉注意力将人脸特征引入扩散模型中。并且,作者仿照ControlNet,构造了一个IdentityNet,将人脸的位置信息和前面提取的人脸特征作为输入指导图片的生成。整个模型中,只有新加入的模块需要训练,文生图的基础模型不需要训练。

作者提出了InstantID,一种全新的ID一致的预训练文生图模型的调整方法。其在相同基础模型的模型下具有即插即用的特性。

模型首先提取人脸的特征(使用专门针对人脸的模型而非CLIP,因为作者认为CLIP提取的特征具有很多人脸无关的信息,无法关注到人脸的细节特征),之后映射到文本特征空间,之后像IP-Adapter一样使用额外的交叉注意力将人脸特征引入扩散模型中。并且,作者仿照ControlNet,构造了一个IdentityNet,将人脸的位置信息和前面提取的人脸特征作为输入指导图片的生成。整个模型中,只有新加入的模块需要训练,文生图的基础模型不需要训练。

- 数据:LAION-Face + 额外数据集

- 指标:更多是直观比较,无定量分析

- 硬件:48 H100/bs2

- 开源: