Stand-In

ConceptAttention

StoryMem

VideoLCT

MotionInversion

SkyReels-A2

BindWeave

Saber

MAGREF

PolyVivid

VACE

Phantom

LoRAinLoRA

DreamRelation

LeMiCa

AdaCache

FasterCache

PAB

SVG

TeaCache

FreeInit

Peekaboo

TV-LiVE

Enhance-A-Video

FlowDirector

FollowYourMotion

DynamicConcepts

FlowEdit

MOFT

RoPECraft

AnalysisAttentionVDiT

DiTFlow

FreeTraj

FreeNoise

SimulateMotion

DiTCtrl

MagicComp

Video-MSG

Show-o

Chameleon

Flamingo

Emu2

Emu

Emu3

InstantStyle

MotionClone

VMC

MIP-Adapter

TS-LLaVA

Video-ChatGPT

Thinking in Space

FreeVideoLLM

IG-VLM

FreeVA

VTimeLLM

LLoVi

SF-LLaVA

DragDiffusion

DreamMatcher

eDiff-I

Tune-A-Video

SDEdit

PnP-Diffusion

DAAM

Imagic

DemoCaricature

MasaCtrl

Layer-Guidance

SelfGuidance

LLM-grounded Diffusion

Prompt-Mixing

MultiDiffusion

JeDi

PersonalizedResidual

DisenDiff

CrossInitialization

Null-text Inversion

FreeU

AnyDoor

PreciseControl

CosmicMan

FlashFace

ConsistentID

CapHuman

Face2Diffusion

PortraitBooth

Cones2

CAFE

Cones

Mix-of-Show

P+

Attend-and-Excite

FaceCaption-15M

Face-diffuser

PuLID

CelebBasis

W+Adapter

DreamIdentity

MagiCapture

Subject-Diffusion

ViCo

Universal Guidance for Diffusion Models

SSR-Encoder

HyperDreamBooth

COW

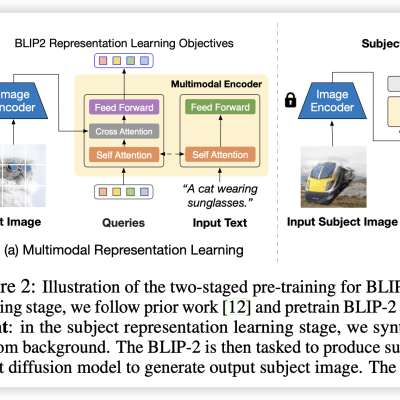

BLIP-Diffusion

MasterWeaver

Continual Diffusion(C-LoRA)

Taming Encoder

InstructPix2Pix

UMM-Diffusion

IDAdapter

PhotoVerse

DisenBooth

T2I-Adapter

E4T

Prompt-to-Prompt

Break-A-Scene

Face0

SVDiff

FastComposer

InstantBooth

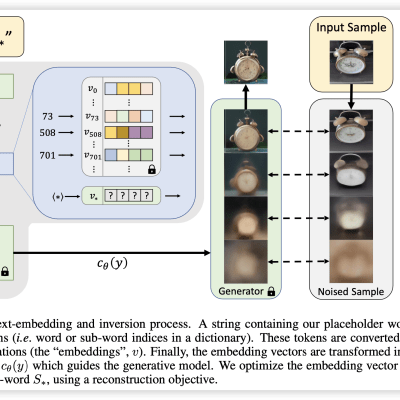

Textual Inversion

Imagen

Re-Imagen

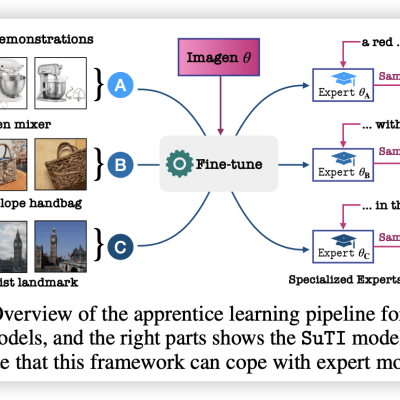

SuTI

ELITE

Custom Diffusion

DreamBooth

IP-Adapter

ControlNet

Asyrp

InstantID

PhotoMaker