- 文章标题:T2I-Adapter: Learning Adapters to Dig out More Controllable Ability for Text-to-Image Diffusion Models

- 文章地址:https://arxiv.org/abs/2302.08453

- AAAI 2024

文生图模型具有惊人的生成能力,然而仅仅通过文本prompt驱动模型不能完全发挥出模型的性能,特别是当需要一些灵活精确的控制(如结构)。

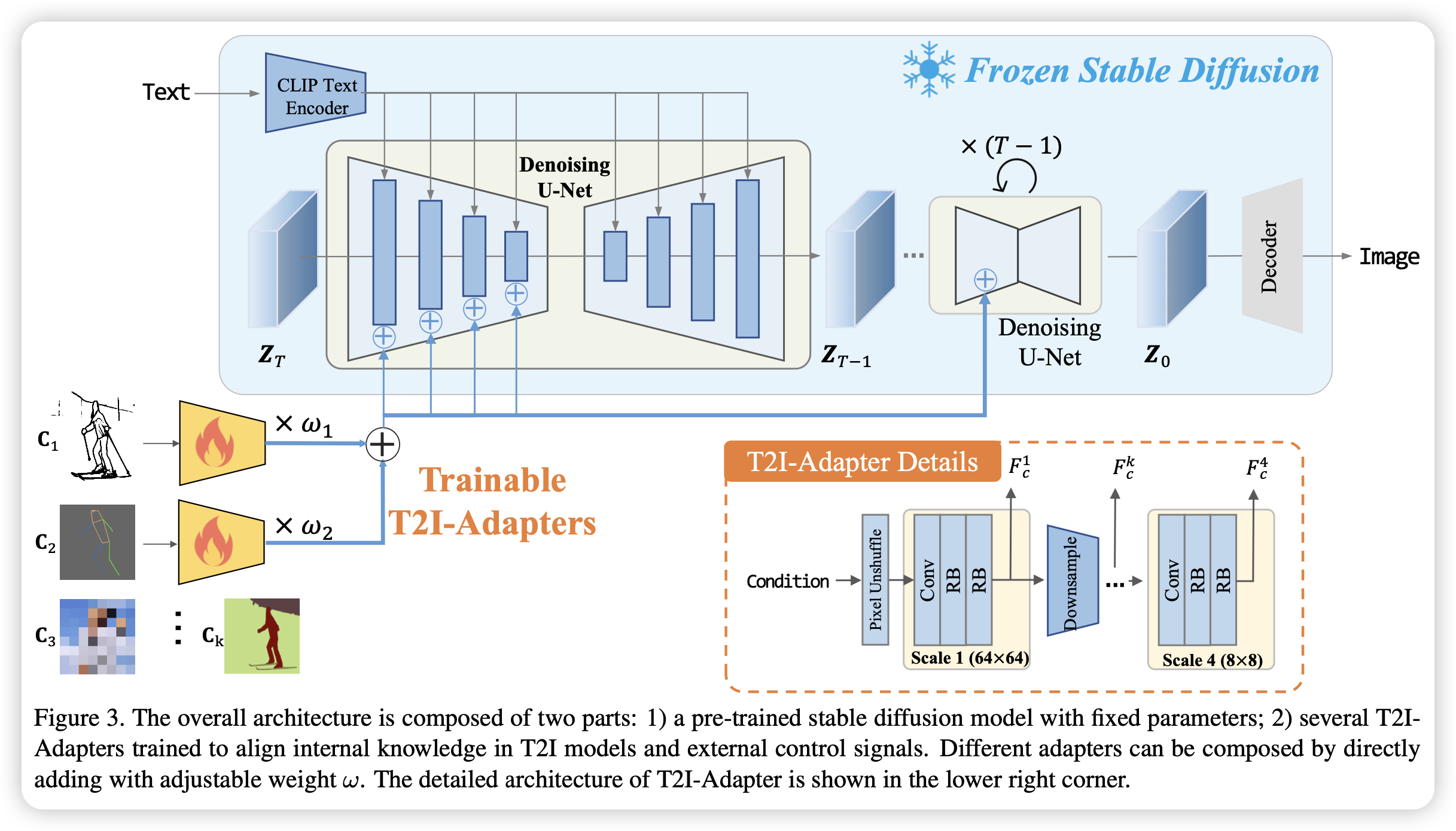

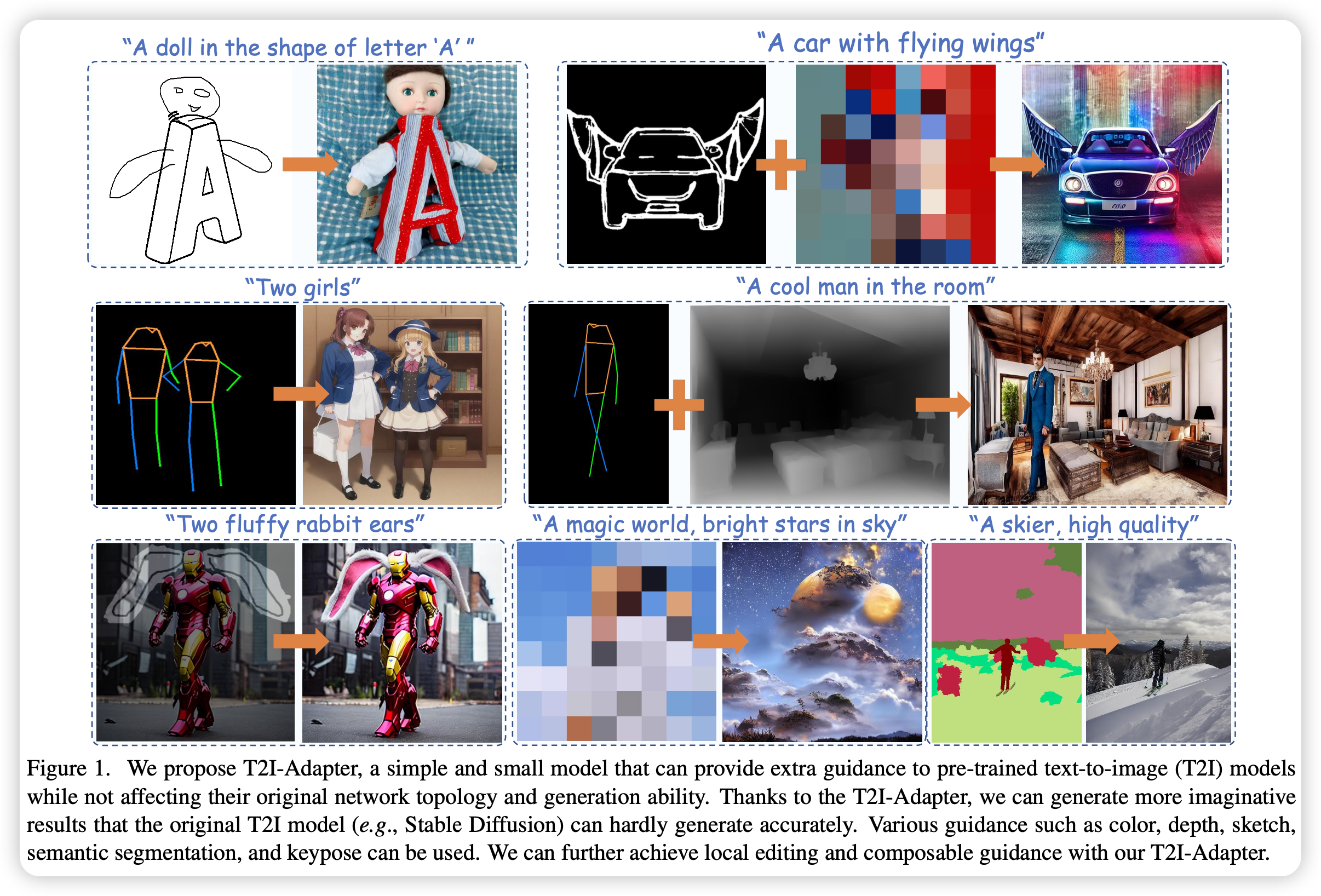

这篇文章目标为挖掘文生图模型本身具有的能力,并且利用他们进行更精准的控制生成。具体来说,文章提出了简单且轻量化的T2I-Adapters,用于模型内在知识与外部控制条件的对齐,且在冻结原有模型的情况下。通过这种方法,可以训练多个adapters针对多种条件,从而实现精准且丰富的控制方式。同时,T2I-Adapters具有组合性和泛化性的特性,从而支持多种应用。

文生图模型具有惊人的生成能力,然而仅仅通过文本prompt驱动模型不能完全发挥出模型的性能,特别是当需要一些灵活精确的控制(如结构)。

这篇文章目标为挖掘文生图模型本身具有的能力,并且利用他们进行更精准的控制生成。具体来说,文章提出了简单且轻量化的T2I-Adapters,用于模型内在知识与外部控制条件的对齐,且在冻结原有模型的情况下。通过这种方法,可以训练多个adapters针对多种条件,从而实现精准且丰富的控制方式。同时,T2I-Adapters具有组合性和泛化性的特性,从而支持多种应用。

- 数据:对不同的条件利用了不同的数据集,草图(COCO17);语义分割图(COCO-Stuff);关键点&颜色&深度图(LAION-AESTHETICS)

- 指标:FID;CLIP Score

- 硬件:4 V100/bs8

- 开源:https://github.com/TencentARC/T2I-Adapter