- 文章标题:Universal Guidance for Diffusion Models

- 文章地址:https://arxiv.org/abs/2302.07121

- CVPR 2023

当前的扩散模型对于条件生成只能支持一种模态的条件,无法在不重新训练下引入新模态的条件,在这篇文章,提出了一个统一引导条件的算法,能够使扩散模型在不需要任何训练就能引入任意模态的引导条件控制生成。文章展示了在文本、分割图、人脸等条件下优秀的生成结果。

总的来说,方法就是classifier-guidance的变种,将各种模型和损失替换了classifier,从而能够使模型生成想要的结果。

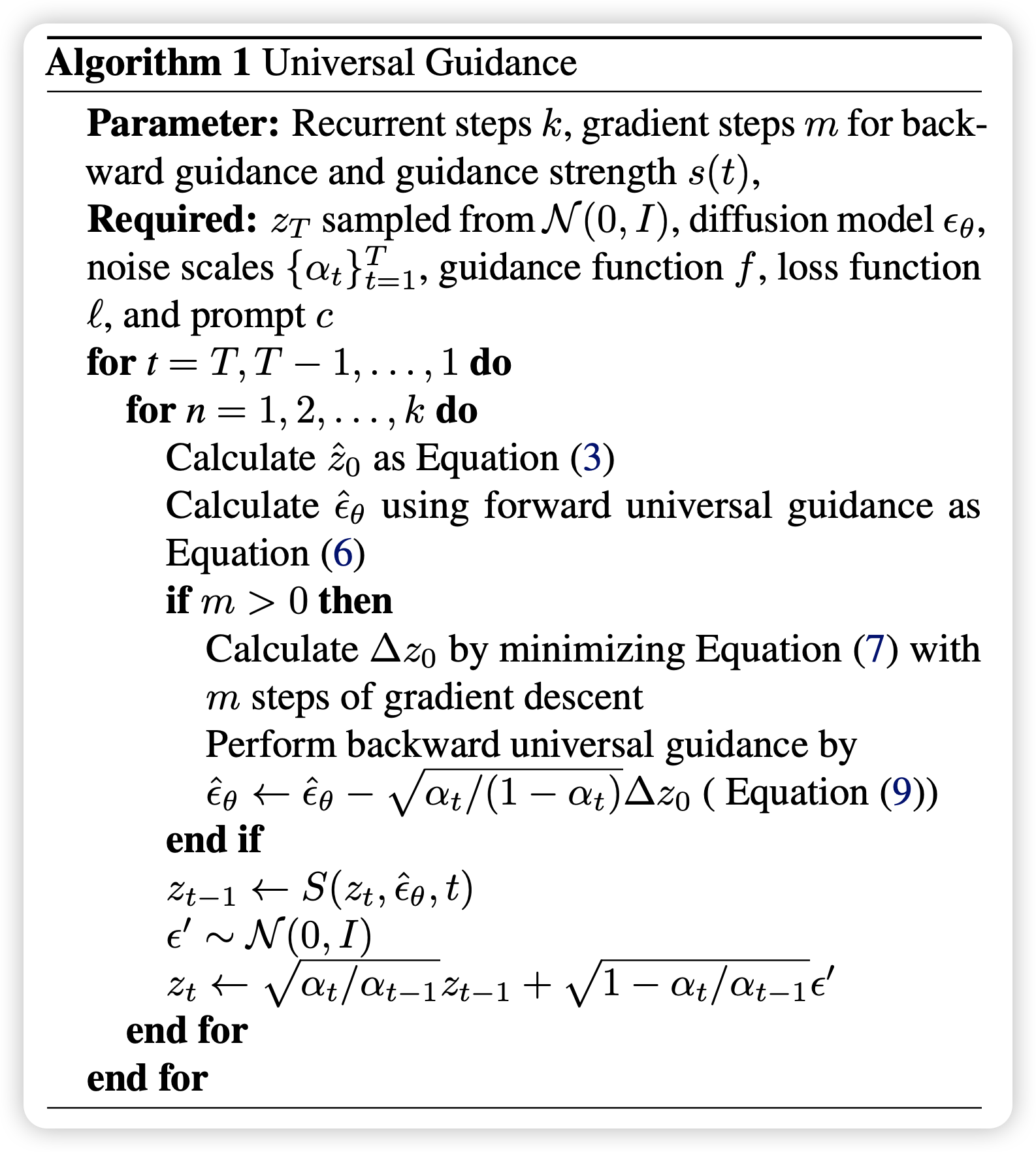

具体来说,算法首先进行前向引导,但如果使用中间变量(带噪声)进行损失的计算会产生较差的结果,因为额外的引导模型不支持带噪声的图像,从而作者就使用扩散模型的公式,在该点直接预测原图,引导模型利用原图进行计算,如此来完成前向引导。单单使用前向引导效果不好,作者提出进行反向引导,其实就是对预测的噪声进行一个修正,使其预测的原图更符合条件。最后,由于生成的图像真实性差很多,算法还提出了逐步自递归的一个方法,简单来说就是将每一步重复这个过程m次得到质量更高的图像。

当前的扩散模型对于条件生成只能支持一种模态的条件,无法在不重新训练下引入新模态的条件,在这篇文章,提出了一个统一引导条件的算法,能够使扩散模型在不需要任何训练就能引入任意模态的引导条件控制生成。文章展示了在文本、分割图、人脸等条件下优秀的生成结果。

总的来说,方法就是classifier-guidance的变种,将各种模型和损失替换了classifier,从而能够使模型生成想要的结果。

具体来说,算法首先进行前向引导,但如果使用中间变量(带噪声)进行损失的计算会产生较差的结果,因为额外的引导模型不支持带噪声的图像,从而作者就使用扩散模型的公式,在该点直接预测原图,引导模型利用原图进行计算,如此来完成前向引导。单单使用前向引导效果不好,作者提出进行反向引导,其实就是对预测的噪声进行一个修正,使其预测的原图更符合条件。最后,由于生成的图像真实性差很多,算法还提出了逐步自递归的一个方法,简单来说就是将每一步重复这个过程m次得到质量更高的图像。

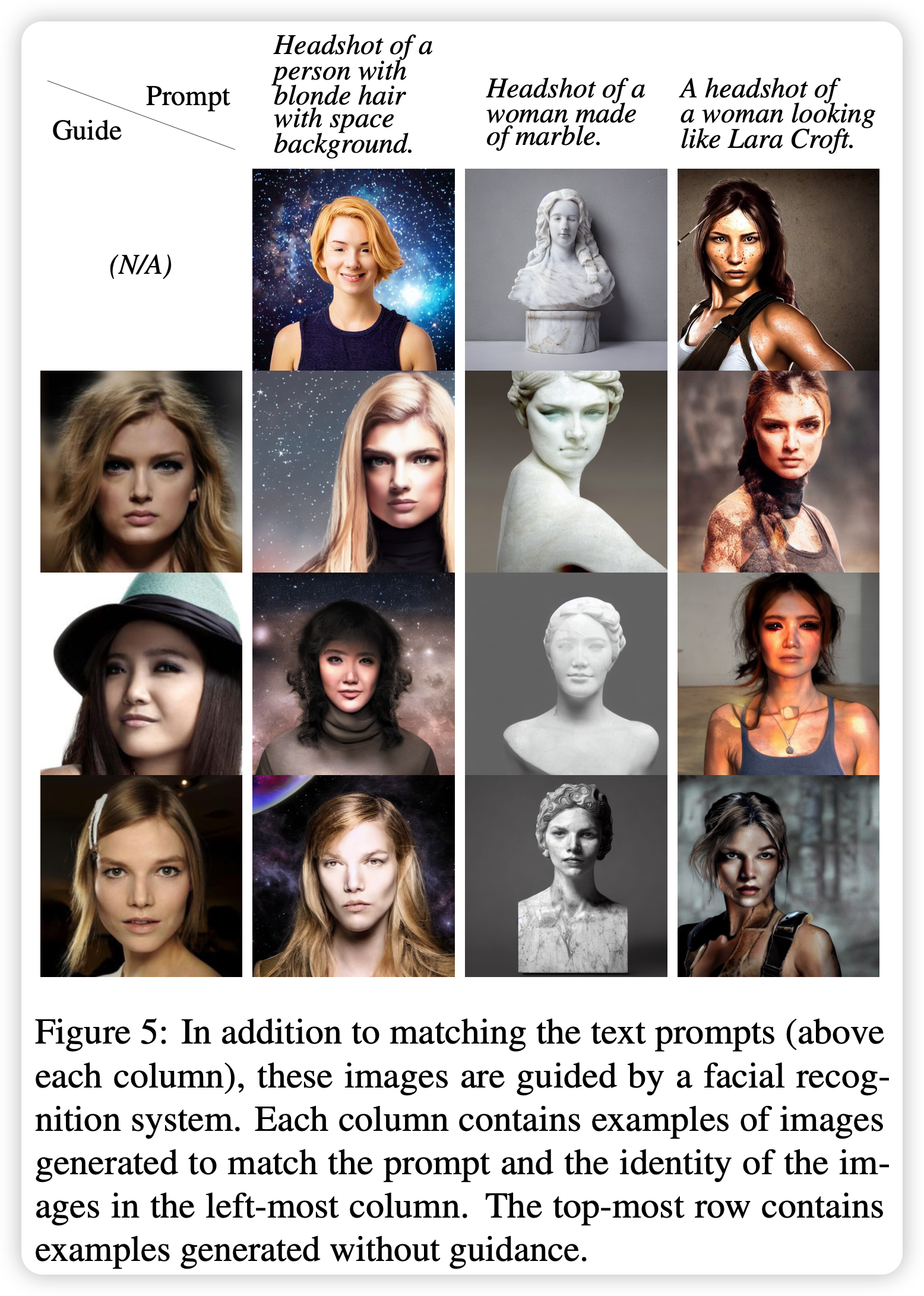

这篇文章利用人脸识别模型作为特征提取器对生成的图像与参考图像的特征进行损失的计算,以此来引导图像的生成,取得了不错的效果,这是一个以前没有看到过的方法,无需测试训练。

这篇文章利用人脸识别模型作为特征提取器对生成的图像与参考图像的特征进行损失的计算,以此来引导图像的生成,取得了不错的效果,这是一个以前没有看到过的方法,无需测试训练。

- 数据:无需

- 指标:无

- 硬件:未知

- 开源:https://github.com/arpitbansal297/Universal-Guided-Diffusion